[*] Il presente contributo si sofferma sulla regolamentazione europea dell’intelligenza artificiale, nel confronto con altri ordinamenti extra-UE, sottolineando l’esigenza di una maggiore proporzionalità regolatoria, al fine di meglio responsabilizzazione gli operatori e puntare su adeguati investimenti.

Abstract

Il contributo prende le mosse dall’intervento di Mario Draghi al Politecnico di Milano, nel quale l’intelligenza artificiale (IA) è collocata al centro della diagnosi sul ritardo di produttività e di competitività dell’Europa. A partire da una prospettiva dichiaratamente non specialistica sul piano tecnico-informatico, il saggio propone tre linee di riflessione: (i) la rilettura della generazione dei cosiddetti “boomer” come testimone privilegiato di decenni di trasformazioni tecnologiche; (ii) una valutazione critica, ma costruttiva, del paradigma regolatorio europeo in materia di IA, alla luce dell’AI Act e del confronto con altri grandi ordinamenti (Stati Uniti, Cina, India, Russia); (iii) il richiamo alla distinzione pasoliniana tra sviluppo e progresso quale chiave interpretativa per evitare tanto l’entusiasmo ingenuo quanto il rifiuto difensivo dell’innovazione. Ne emerge l’esigenza di una regolazione maggiormente proporzionata, orientata alla responsabilizzazione degli operatori e sorretta da adeguati investimenti in capacità istituzionali e infrastrutturali, al fine di coniugare ambizione tecnologica e tutela sostanziale dei diritti fondamentali.

1. Introduzione e premessa metodologica

Il punto di partenza di questo contributo è una premessa di onestà intellettuale: l’autore non si qualifica come “esperto” di intelligenza artificiale in senso tecnico-informatico. La conoscenza dei modelli, delle architetture di machine learning e delle soluzioni algoritmiche di frontiera appartiene, in modo legittimo, a comunità specialistiche. A fronte di ciò, il dibattito pubblico contemporaneo è abitato da una molteplicità di voci che, nei media come nelle arene politiche, adottano spesso toni perentori a proposito di una tecnologia che richiederebbe invece, per sua natura, prudenza concettuale e consapevolezza dei limiti della conoscenza disponibile.

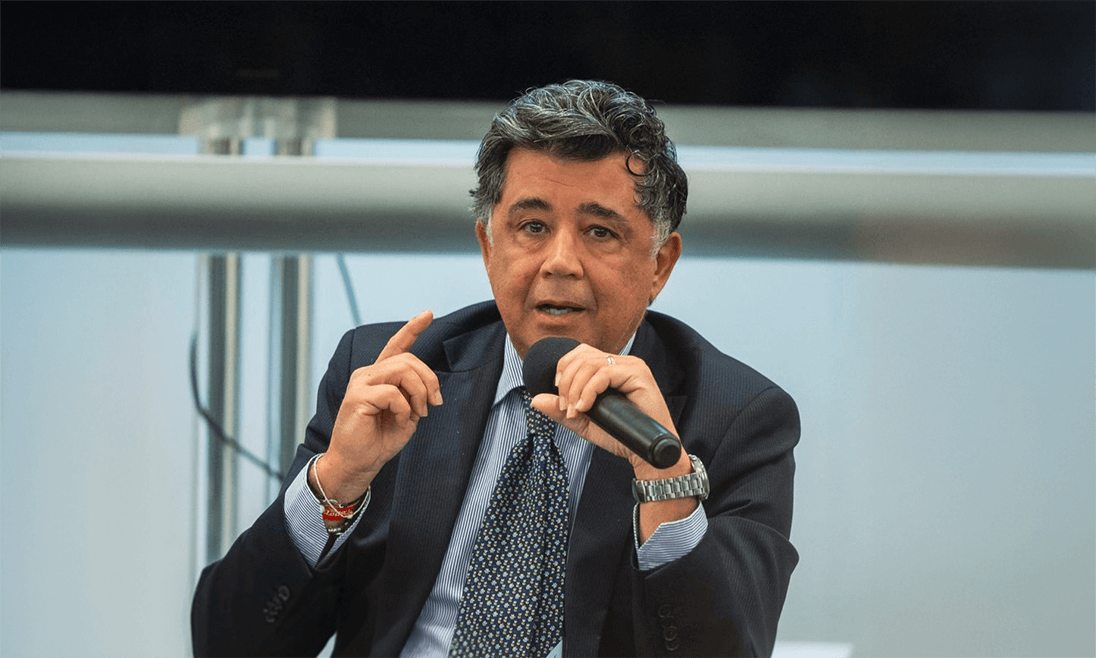

Da questa posizione “profana”, ma non per questo meno impegnata, si propone uno sguardo sull’IA come fenomeno giuridico, economico e culturale. È lo sguardo che si rintraccia, con ben altra autorevolezza, nell’intervento tenuto da Mario Draghi al Politecnico di Milano, in occasione dell’inaugurazione dell’anno accademico, in cui l’ex Presidente della Banca centrale europea riconduce l’IA al cuore delle criticità strutturali europee: stagnazione della produttività, ritardo negli investimenti privati in tecnologie avanzate, frammentazione dei mercati e conseguente erosione della competitività del continente.

Il discorso di Draghi si colloca in una tradizione di analisi che attribuisce al progresso tecnico un ruolo decisivo nella crescita del tenore di vita degli ultimi due secoli. La tesi di fondo è nota: oltre un certo punto, lavoro e capitale non sono sufficienti a sostenere aumenti significativi di produttività se non accompagnati da innovazioni di processo e di prodotto. L’intelligenza artificiale, in quanto tecnologia abilitante trasversale, è individuata come uno dei principali strumenti per tentare di invertire una traiettoria altrimenti segnata da un lento declino.

2. La generazione dei “boomer” come testimone privilegiato del cambiamento tecnologico

In un dibattito pubblico spesso dominato da semplificazioni, la generazione dei cosiddetti “boomer” è frequentemente rappresentata come ostacolo alla modernizzazione: portatrice di resistenze culturali, presunta tecnofobia, incapacità strutturale di comprendere le logiche del digitale. Tale narrazione, oltre a essere riduttiva sul piano sociologico, rischia di oscurare un dato empirico rilevante: le biografie professionali di queste generazioni sono attraversate da una sequenza di trasformazioni tecnologiche senza precedenti per intensità e frequenza.

Ci si è mossi dal lavoro amministrativo fondato sul lapis rosso e blu, sui timbri, sulla carta carbone, per approdare progressivamente alle calcolatrici manuali e tascabili, ai telefoni a disco e successivamente a tasti, ai primi telefoni cellulari, all’introduzione del personal computer nei contesti lavorativi, fino alla smaterializzazione quasi integrale dei flussi documentali tramite fax, posta elettronica, sistemi gestionali e piattaforme cloud. In tempi più recenti, le stesse generazioni sono chiamate a confrontarsi con strumenti di automazione avanzata e applicazioni di intelligenza artificiale generativa.

Questo percorso non è stato vissuto in modo meramente passivo. I soggetti oggi etichettati come boomer hanno dovuto apprendere nuovi linguaggi, ridefinire procedure, ripensare prassi consolidate, ridistribuire competenze e responsabilità all’interno delle organizzazioni. In altre parole, essi hanno esercitato una forma di competenza adattiva che li rende, in un certo senso, “esperti del cambiamento”: non tanto per la padronanza dell’ultima applicazione, quanto per la capacità di governare nel tempo transizioni tecnologiche successive e non prive di costi organizzativi e sociali.

Il recupero di questa memoria storica appare particolarmente utile nel momento in cui l’IA viene spesso narrata come rottura assoluta, tale da rendere obsoleto ogni riferimento a esperienze pregresse. Al contrario, proprio la stratificazione delle innovazioni vissute da queste generazioni suggerisce di diffidare sia delle retoriche salvifiche, sia delle derive catastrofiste, orientando l’attenzione verso gli strumenti di governo – normativi, organizzativi e culturali – delle trasformazioni in atto.

3. L’intelligenza artificiale nella diagnosi di Draghi sulla competitività europea

Nel suo intervento al Politecnico di Milano, Draghi propone una diagnosi severa della posizione europea nell’economia globale. La produttività del lavoro cresce in modo modesto, il mercato dei capitali resta segmentato, i livelli di investimento in ricerca e sviluppo, in particolare nei settori ad alta intensità tecnologica, risultano inferiori rispetto ai principali concorrenti. In questo quadro, l’IA è collocata al centro non tanto in quanto oggetto di fascinazione tecnologica, quanto come indicatore e strumento di politica economica.

L’intelligenza artificiale è infatti concepita come infrastruttura abilitante di una pluralità di processi: dall’ottimizzazione delle catene produttive alla personalizzazione dei servizi, dalla gestione dei sistemi energetici alla sanità, fino alla stessa organizzazione delle amministrazioni pubbliche. In termini giuridici, ciò implica che le scelte regolatorie in materia di IA non possono essere relegate a un ambito tecnico settoriale, ma assumono una valenza di politica industriale e di politica della concorrenza.

Se, come suggerisce Draghi, l’Europa si trova in una fase in cui l’innovazione tecnologica è condizione necessaria per evitare un declino di lungo periodo, la questione non è se disciplinare l’IA, ma come farlo in modo tale da non sterilizzarne il potenziale, preservando al contempo l’orizzonte di tutela dei diritti fondamentali che caratterizza, almeno sul piano normativo, l’esperienza giuridica europea.

4. L’AI Act nel contesto del diritto dell’Unione: logica risk-based e nodi critici

Il Regolamento (UE) 2024/1689 (cd. AI Act) rappresenta il tentativo più organico di costruire, a livello sovranazionale, una disciplina orizzontale dei sistemi di intelligenza artificiale.

L’impianto si fonda su una classificazione delle applicazioni in base al rischio: alcune pratiche sono qualificate come di rischio inaccettabile e dunque vietate; altre sono configurate come “ad alto rischio” e sottoposte a requisiti stringenti in termini di governance, qualità dei dati, trasparenza e supervisione umana; per le applicazioni a rischio limitato o minimo sono previste prescrizioni meno vincolanti o misure volontarie.

La logica di fondo è coerente con la tradizione dell’Unione in materia di regolazione di prodotti e servizi potenzialmente rischiosi: l’obiettivo dichiarato è quello di garantire un elevato livello di protezione dei diritti fondamentali, della salute e della sicurezza, preservando al contempo lo spazio per l’innovazione. Tuttavia, la combinazione tra AI Act, disciplina sulla protezione dei dati personali, norme in materia di responsabilità civile e interventi di matrice antitrust solleva alcune criticità (solo citando alcune fonti di esposizione delle imprese a responsabilità di peculiare afflittività nonché costosi interventi di prevenzione non sempre giustificati).

In primo luogo, i costi di conformità ex ante tendono a gravare in misura sproporzionata sulle start-up e sulle piccole e medie imprese, che dispongono di risorse limitate per strutture legali e di compliance, a differenza dei grandi operatori globali. In secondo luogo, la perimetrazione delle categorie di rischio e la loro interpretazione concreta non risultano sempre di immediata chiarezza, alimentando un clima di incertezza che può indurre strategie difensive e rinvii nell’adozione di soluzioni innovative.

Infine, l’ampiezza del catalogo sanzionatorio, in linea con altre esperienze regolatorie europee, rischia di consolidare una percezione dell’IA come fenomeno primariamente da contenere e sanzionare, più che da orientare e responsabilizzare. Si profila così il rischio di un eccesso di cautela regolatoria che, nella prassi, potrebbe tradursi in una forma di autolimitazione della capacità competitiva europea.

In questo quadro merita una specifica riflessione anche il modo in cui le fattispecie sanzionate sono costruite nelle normative “contemporanee” che più spesso vengono accostate all’AI Act: basti pensare, da un lato, al regime dei rinvii e dei poteri correttivi previsto dal GDPR e, dall’altro, alla disciplina antitrust e di vigilanza sui mercati finanziari. Si tratta di settori nei quali il legislatore europeo e nazionale hanno progressivamente fatto ricorso a clausole generali, concetti giuridici indeterminati e poteri ampiamente discrezionali delle autorità indipendenti, con il dichiarato obiettivo di conservare flessibilità regolatoria di fronte a fenomeni economici e tecnologici in rapida evoluzione, ma con l’effetto collaterale di porre in tensione i parametri, di matrice penalistica, di tassatività e determinatezza, tradizionalmente presidio del principio di legalità.

Come è noto, la giurisprudenza della Corte europea dei diritti dell’uomo ha da tempo chiarito, a partire dalla sentenza Engel e altri c. Paesi Bassi (8 giugno 1976), che la nozione convenzionale di “materia penale” è autonoma rispetto alle qualificazioni formali del diritto interno e che anche sanzioni formalmente amministrative possono rientrare nel campo di applicazione degli articoli 6 e 7 CEDU quando presentino una funzione prevalentemente afflittiva e repressiva. Tale impostazione è stata ribadita, tra l’altro, nelle decisioni Öztürk c. Germania (21 febbraio 1984) e Jussila c. Finlandia (23 novembre 2006), nonché – con riferimento alle sanzioni antitrust e di market abuse – in A. Menarini Diagnostics S.r.l. c. Italia (27 settembre 2011) e in Grande Stevens e altri c. Italia (4 marzo 2014), ove le sanzioni irrogate dalle autorità indipendenti italiane sono state qualificate come “penali” in senso convenzionale proprio in ragione della loro gravità e finalità punitiva.

Sia una parte autorevole della dottrina (si pensi, ad esempio, ai contributi di commento alle pronunce Menarini e Grande Stevens, che hanno parlato espressamente di “diritto amministrativo punitivo”), sia la giurisprudenza successiva hanno valorizzato la natura parapenale di tali sanzioni – anche in ambiti come la protezione dei dati personali, la concorrenza e i mercati finanziari – per richiedere un più rigoroso rispetto dei principi di legalità, prevedibilità e proporzionalità, nonché una più attenta costruzione delle fattispecie tipiche. In questa prospettiva, la tensione tra esigenze di flessibilità regolatoria e garanzie di tassatività non può più essere confinata al solo diritto penale in senso stretto, ma investe l’intero “diritto punitivo” europeo, entro cui si collocano oggi anche gli apparati sanzionatori del GDPR, dell’AI Act e delle discipline antitrust. Il richiamo alla giurisprudenza convenzionale, lungi dal costituire un mero vincolo esterno, può allora fungere da stimolo per ripensare il disegno delle sanzioni in chiave più garantista e maggiormente attenta alla qualità delle tecniche di tipizzazione normativa.

5. Profili comparati: Stati Uniti, Cina, India, Russia

La specificità dell’approccio europeo emerge con maggiore chiarezza se confrontata con le principali scelte regolatorie di altri ordinamenti. Negli Stati Uniti, l’assenza di un’analoga disciplina federale onnicomprensiva è compensata da un insieme di atti di soft law, linee guida settoriali e interventi di agenzie indipendenti (quali, ad esempio, il NIST o la Federal Trade Commission), nonché da un ordine esecutivo presidenziale che indirizza lo sviluppo sicuro e affidabile dell’IA. L’enfasi è posta su responsabilità ex post, tutela del consumatore e concorrenza, in un contesto di elevata propensione all’investimento privato.

La Cina adotta un modello in cui regolazione e politica industriale risultano strettamente integrate. Accanto a discipline specifiche sugli algoritmi di raccomandazione, sui deepfake e sull’IA generativa, si collocano piani strategici pluriennali che fissano il traguardo della leadership globale in ambito IA entro orizzonti temporali definiti. Lo Stato svolge un ruolo di regolatore, investitore e grande committente, con una capacità di mobilitazione di risorse difficilmente replicabile nel contesto europeo.

L’India ha finora privilegiato un approccio definito “light-touch”, basato su strategie nazionali, linee guida e strumenti di promozione dell’uso dell’IA soprattutto nei servizi pubblici e nei progetti di digitalizzazione di massa. L’attenzione è rivolta alla dimensione dell’inclusione e dell’ampliamento dell’accesso ai servizi, più che alla costruzione di un apparato prescrittivo centralizzato.

La Russia, infine, mantiene un quadro relativamente permissivo in ambito civile, concentrando i profili più stringenti sulle applicazioni militari e di sicurezza. In tutti questi casi, si osserva una tendenza, pur con differenze rilevanti, a concentrare gli sforzi regolatori sulle aree di rischio più elevato, lasciando spazi più ampi alla sperimentazione in altri settori.

Il confronto suggerisce che l’Unione europea rischia di specializzarsi in uno “sviluppo normativo” che non trova un corrispondente avanzamento nella capacità di sviluppare e attrarre tecnologie di frontiera, con possibili ricadute sulla posizione dell’Europa nelle catene globali del valore.

6. Verso un paradigma regolatorio alternativo: proporzionalità, responsabilità, capacità istituzionale

La consapevolezza di questi limiti non implica la messa in discussione del ruolo della regolazione, bensì la necessità di ripensarne il paradigma. Un primo asse riguarda la proporzionalità effettiva degli oneri: occorre evitare che applicazioni a rischio contenuto siano gravate da requisiti eccessivi, riservando la massima attenzione alle aree effettivamente ad alto impatto sui diritti fondamentali e sulle infrastrutture critiche. In questa prospettiva, strumenti quali le sandbox regolatorie possono costituire un laboratorio utile per conciliare sperimentazione e tutela.

Un secondo asse concerne la centralità della responsabilità e dei rimedi. Piuttosto che moltiplicare autorizzazioni e controlli preventivi, il baricentro potrebbe essere spostato sulla tracciabilità delle decisioni automatizzate, sulla chiarezza della catena delle responsabilità e sulla effettività dei meccanismi di tutela per gli individui che subiscano un pregiudizio. L’obiettivo è evitare che l’IA diventi una “zona grigia” in cui la responsabilità si disperde tra sviluppatori, fornitori e utilizzatori.

Un terzo asse riguarda l’investimento in capacità istituzionale e infrastrutturale. Nessun corpus normativo può funzionare senza autorità di vigilanza adeguatamente dotate di competenze e risorse, né senza un sistema giudiziario in grado di comprendere la natura tecnica delle controversie che inevitabilmente sorgeranno. Al contempo, una strategia europea credibile sull’IA richiede infrastrutture di calcolo, politiche dei dati e modelli di cooperazione pubblico-privato tali da rendere concretamente praticabile lo sviluppo di soluzioni competitive all’interno del perimetro giuridico europeo.

7. Una chiave di lettura pasoliniana: sviluppo e progresso nell’era dell’IA

Per meglio comprendere la posta in gioco, può essere utile richiamare la distinzione, ormai classica, proposta da Pier Paolo Pasolini tra sviluppo e progresso. Nei suoi scritti sulla società dei consumi, Pasolini distingue lo sviluppo, inteso come crescita quantitativa della produzione e dei consumi, dal progresso, concepito come miglioramento qualitativo della vita collettiva, dei diritti e delle relazioni sociali.

Uno sviluppo privo di progresso è definito “mostruoso”: accresce la ricchezza materiale senza tradursi in maggiore giustizia o libertà, anzi può accompagnarsi a nuove forme di omologazione e marginalizzazione. Applicare questa distinzione all’intelligenza artificiale consente di evitare sia la celebrazione acritica dell’innovazione, sia il suo rifiuto pregiudiziale. La questione non è tanto se avere più o meno IA, quanto che tipo di IA sviluppare e al servizio di quali fini.

Da un lato, un’adozione incontrollata dell’IA, guidata esclusivamente dalla massimizzazione del profitto o dalla logica della sorveglianza, rischia di produrre proprio quello “sviluppo senza progresso” che Pasolini criticava. Dall’altro lato, una posizione di rinuncia preventiva allo sviluppo tecnologico, fondata sulla sfiducia nella capacità di orientarlo, porterebbe a subire tecnologie e standard elaborati altrove, secondo valori e obiettivi non necessariamente coincidenti con quelli europei.

La sfida per l’Unione europea è, in questa prospettiva, quella di coniugare ambizione tecnologica e coerenza valoriale: promuovere uno sviluppo dell’IA che consenta di colmare il divario competitivo, orientandolo al contempo verso un progresso effettivo in termini di dignità della persona, uguaglianza sostanziale e qualità della vita democratica.

8. Conclusioni

La riflessione proposta, pur muovendo da una posizione dichiaratamente non specialistica sul piano tecnico, intende offrire alcuni spunti per un ripensamento del paradigma regolatorio europeo in materia di intelligenza artificiale. La rilettura della generazione dei boomer come testimone privilegiato delle trasformazioni tecnologiche degli ultimi decenni suggerisce che l’esperienza accumulata nel governo del cambiamento può costituire una risorsa, piuttosto che un ostacolo, nella fase attuale.

Il discorso di Draghi al Politecnico di Milano rimarca la centralità dell’IA per uscire da una traiettoria di stagnazione di lungo periodo; l’AI Act rappresenta un tentativo coraggioso, ma non privo di rischi, di tradurre in norma la tensione tra innovazione e tutela. Il confronto con altri ordinamenti evidenzia come un approccio eccessivamente cautelativo possa assumere tratti autolimitanti sul piano della competitività.

In questa cornice, l’evocazione della distinzione pasoliniana tra sviluppo e progresso offre una bussola interpretativa: l’obiettivo non può essere quello di “meno tecnologia”, ma di una tecnologia diversa, orientata in modo coerente con i valori fondativi dell’ordinamento europeo. Ciò richiede una regolazione più proporzionata, centrata sulla responsabilità e sostenuta da adeguate capacità istituzionali, affinché l’Europa possa partecipare, da protagonista, alla definizione dell’architettura tecnologica del XXI secolo.

Bibliografia essenziale

- Draghi, M., Intervento al Politecnico di Milano in occasione dell’inaugurazione dell’anno accademico, testo disponibile sul sito dell’Ateneo e su principali quotidiani economici.

- Unione europea, Regolamento (UE) 2024/1689 del Parlamento europeo e del Consiglio, del 13 giugno 2024, che stabilisce regole armonizzate sull’intelligenza artificiale (Artificial Intelligence Act), in GUUE L 2024/1689 del 12 luglio 2024.

- Commissione europea e Parlamento europeo, documenti di sintesi e schede di lettura sull’AI Act e sulle politiche europee in materia di intelligenza artificiale.

- Stanford University, AI Index Report (varie edizioni), per dati comparativi sugli investimenti in IA a livello globale.

- Pasolini, P. P., Scritti corsari, Garzanti, Milano; Id., Lettere luterane, Einaudi, Torino.

[1] Questa nota è stata realizzata con la collaborazione di AI.